问题描述

Linux 操作系统的 GPU 实例如何进行压力测试以及性能测试?

问题分析

GPU_BURN 是一款开源的软件,可以对 GPU 进行压力测试。

GPU 性能测试使用 CUDA sample 自带的 deviceQuery、bandwith 稳定性测试以及性能测试。

解决方案

所有的测试均需要在 GPU 实例上面安装相对应的 cuda 版本,具体请参考如下步骤。

GPU_BURN

安装GPU_BURN

-

GPU_BURN下载以及使用方法参考文档GPU_BURN下载以及使用方法。

-

安装 GPU_BURN,使用如下命令。

tar zxvf gpu_burn-1.1.tar.gz

-

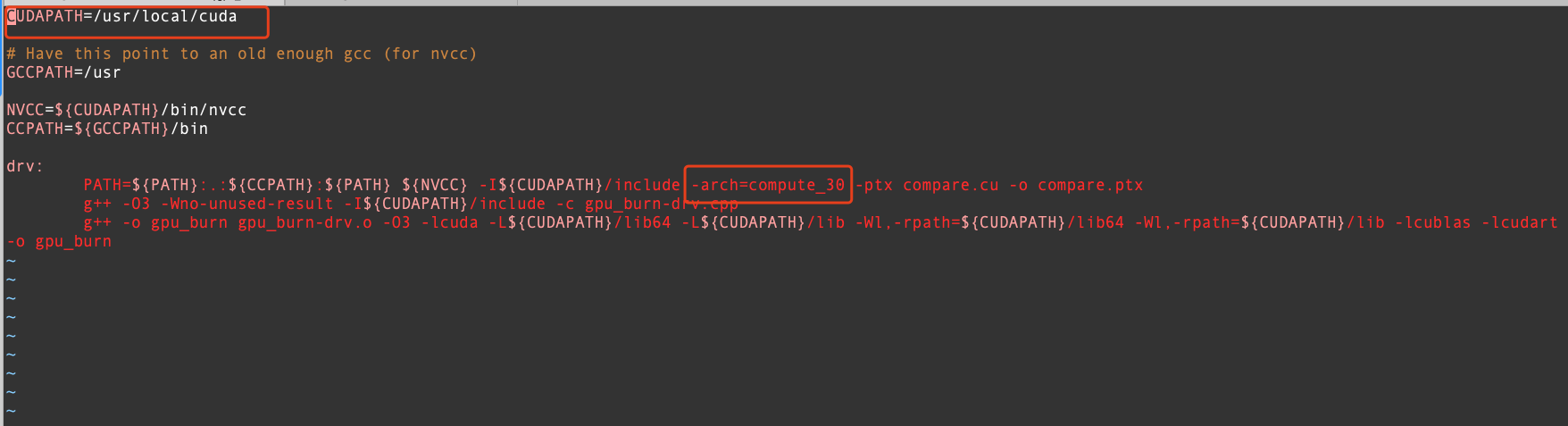

编辑 Makefile,

CUDAPATH=/usr/local/cuda这里更改为自己安装 cuda 的位置即可,删除-arch=compute_30。

-

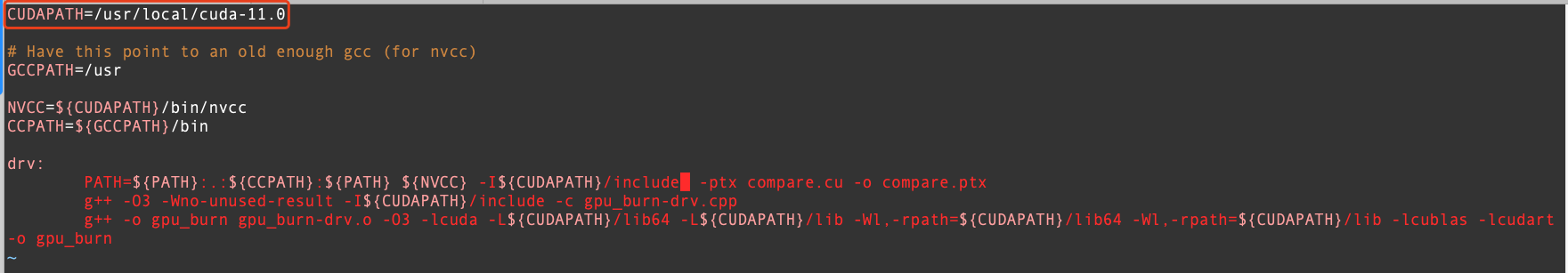

编辑后的配置文件如图所示。

-

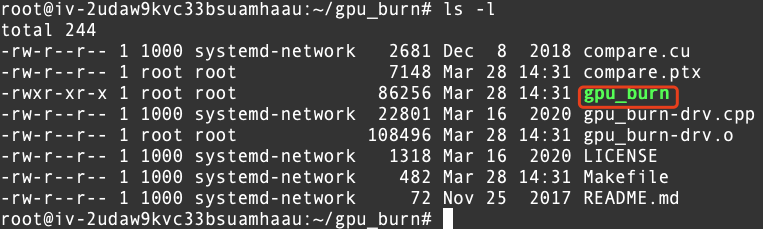

执行

make命令,生成gpu_burn可执行文件,具体如图所示。

使用 GPU_BURN 对 GPU 卡进行压测

-

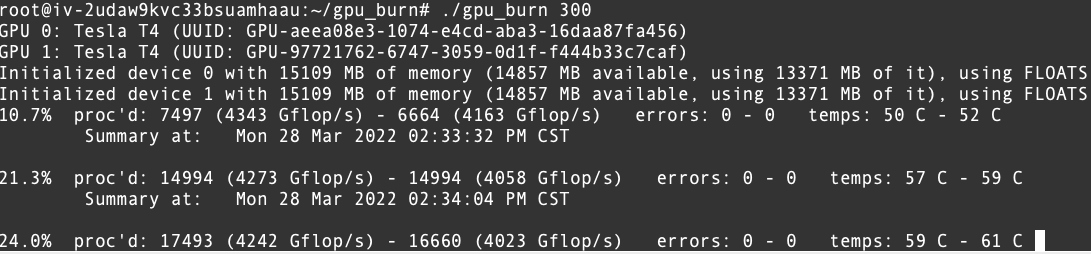

执行命令

./gpu_burn 300执行结果如下。

-

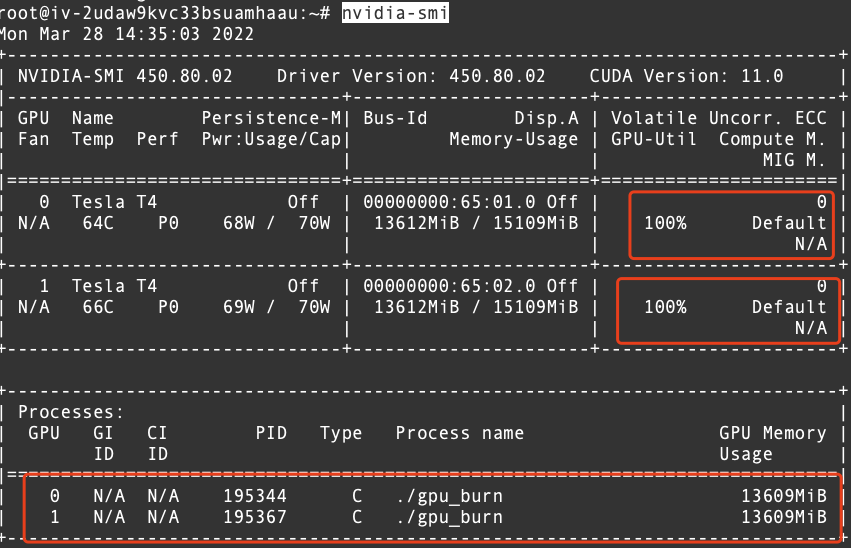

打开其他终端,执行命令

nvidia-smi执行结果如下。

CUDA sample

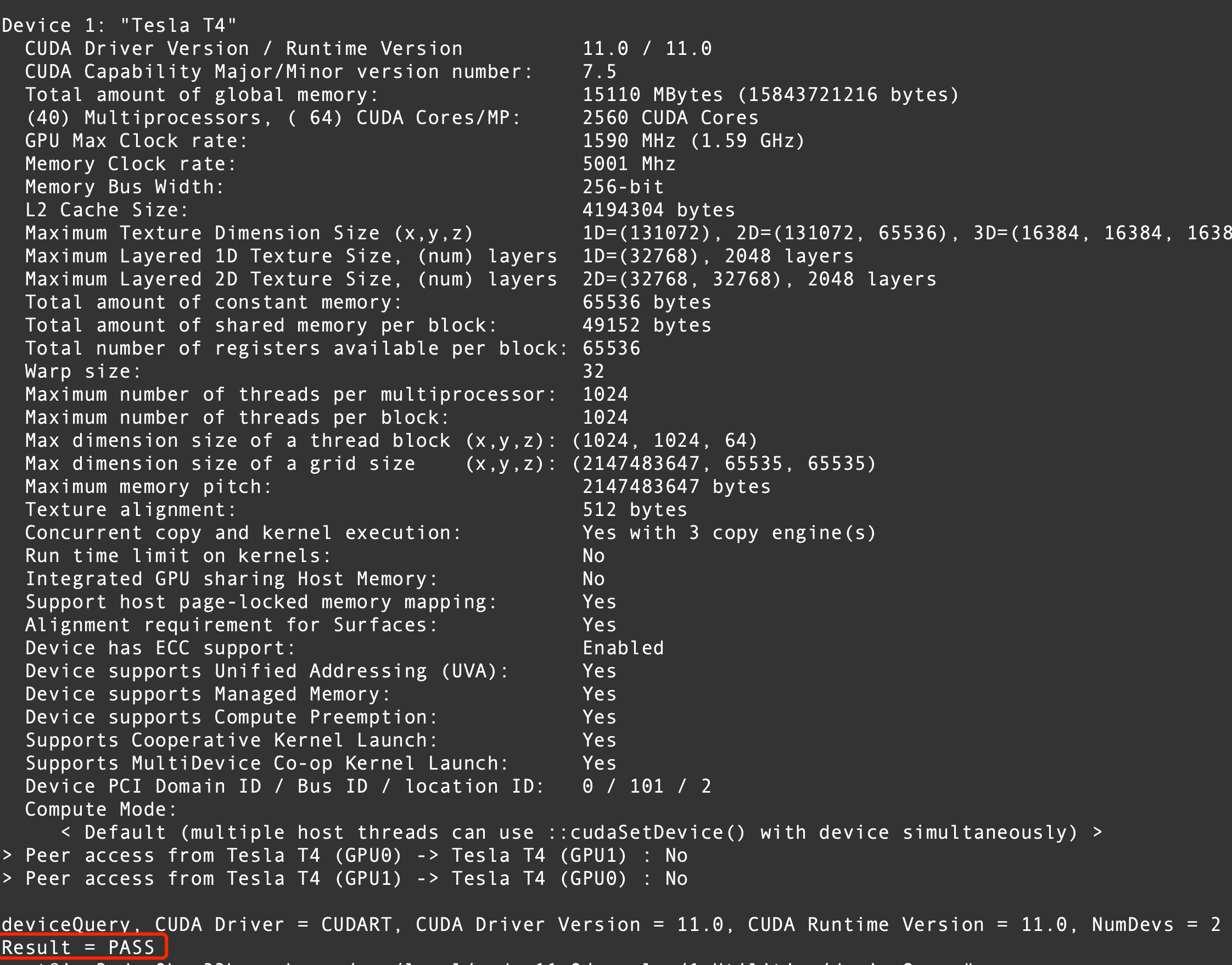

deviceQuery 可用性测试

- 编译二进制文件,并执行可用性测试。

cd c/usr/local/uda-11.0/samples/1_Utilities/deviceQuery

make

./deviceQuery

- 测试结果如下,则 cuda 安装成功。

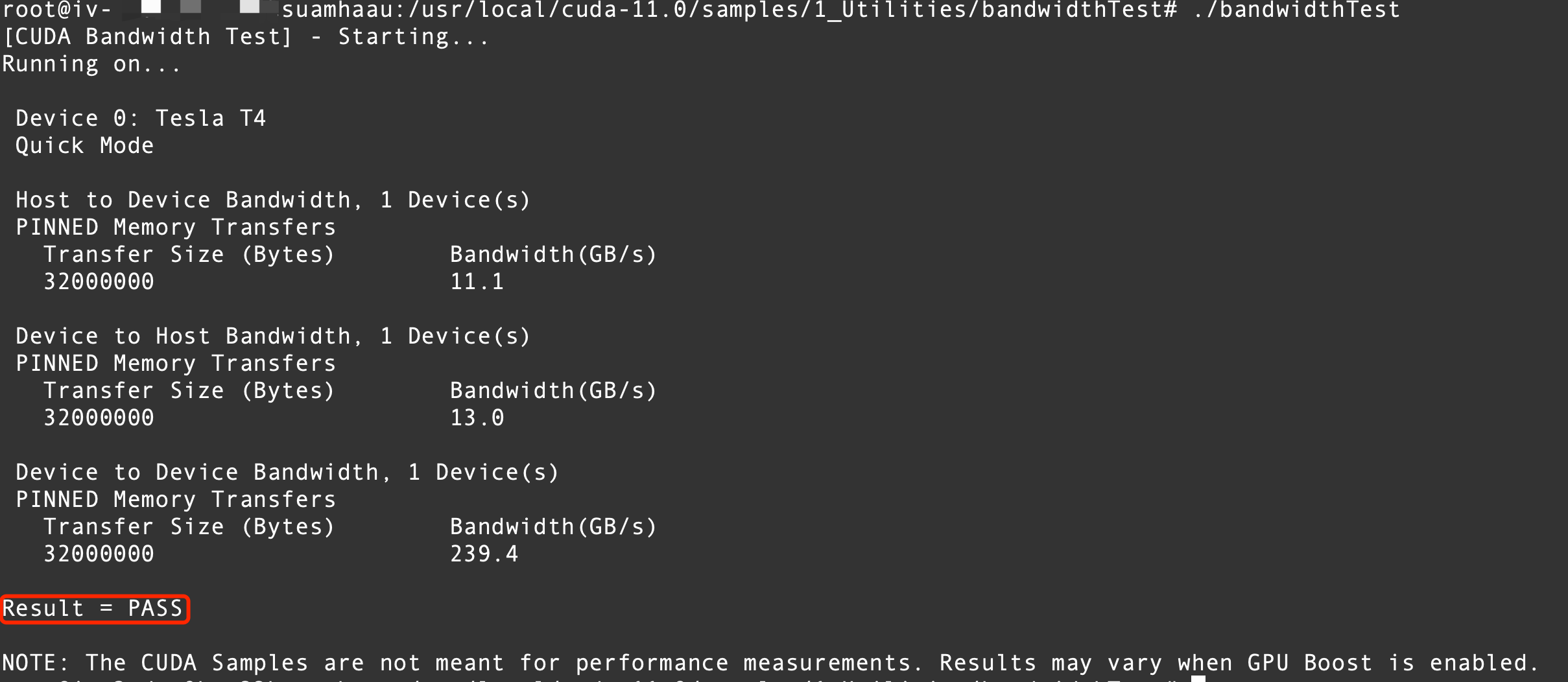

bandwidthTest 带宽测试

- 编译二进制文件,并执行带宽测试。

cd /usr/local/cuda-11.0/samples/1_Utilities/bandwidthTest

make

./bandwidthTest

- 测试结果如下。

关于更多 cuda 以及 sample 的信息请参考英伟达CUDA安装说明。

如果您有其他问题,欢迎您联系火山引擎技术支持服务